Privacy

Intelligenza artificiale: studiamo i dati esistenti prima di produrne di nuovi

Ogni tanto un bel grafico serve. Rinvigorisce il documento, da ritmo la presentazione, rende più semplice interpretare dati complessi.

In un mondo dominato dall’immagine, tanto per ricorrere a un luogo comune, la rappresentazione grafica è uno dei modi principali per esprimere i dati. A loro volta, i numeri e le cifre sono, nel dibattito comune, la quintessenza della verità e del sapere, la pistola da sfoderare nel duello a mezzogiorno.

Se la rappresentazione della realtà affonda le sue radici nelle pitture rupestri, l’idea – strutturata – di trasformare i numeri in immagini che ne descrivessero la relazione è abbastanza recente. Il merito va a William Playfair, il classico uomo dai molti talenti. Nato in Scozia nel 1759, fin da giovane mostrò una spiccata attitudine per l’ingegneria e il disegno. Dopo un apprendistato con l’inventore Andrew Meikle, Playfair divenne assistente personale di James Watt, il pioniere della rivoluzione industriale, frequentando fin da giovane ambienti stimolanti e poliedrici.

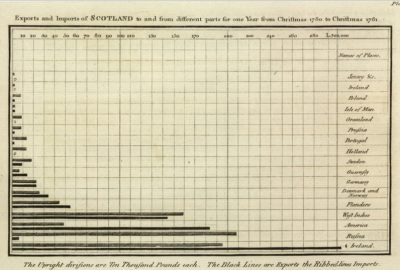

William non era da meno: oltre a essere un abile ingegnere e disegnatore, si cimentò con successo in numerosi altri campi, come l’economia, la statistica, la banca, il giornalismo e persino la scrittura. Ma il suo nome è legato a un’opera, o meglio ad alcune pagine di quell’opera: è nel suo “Commercial and Political Atlas” del 1786 (FIGURA 1) che Playfair presentò per la prima volta diagrammi a barre, diagrammi a torta e altri innovativi metodi di visualizzazione dei dati, anticipando il lavoro di studiosi come Charles Joseph Minard.

FIGURA 1

Il suo merito maggiore fu quindi senza dubbio l’introduzione della rappresentazione grafica in statistica. Probabilmente ne era consapevole anche lui, perché successivamente, nel suo “Statistical Breviary” del 1801, ampliò ulteriormente il repertorio di rappresentazioni grafiche, dimostrando una straordinaria capacità di innovazione, ma rimanendo un personaggio schivo e riservato. Morì a Londra nel 1823, non immaginando che un’intera professione, quella del consulente – e non solo – , avrebbe appoggiato gran parte del suo portfolio sulle sue intuizioni.

FIGURA 2

Proprio sui dati vorrei soffermarmi in questa puntata: per lavoro mi è spesso capitato di dover cercare dati sull’intelligenza artificiale, su quante e quali imprese la utilizzassero e perché. Come immaginabile, nel diluvio di report, opinioni, dibattiti e convegni sul tema, anche i dati si sono moltiplicati, tanto che ognuno, alla fine della giornata, ha la sua percentuale nella fondina.

C’è quindi qualcosa che non torna.

Se i dati sono la verità ma queste stesse cifre sono diverse tra loro, pur se apparentemente destinate a rispondere alla stessa domanda, allora prima di utilizzarli occorre farsi qualche domanda in più.

Su questo tema mi ha profondamente interessato un articolo di C. Thi Nguyen, professore associato di filosofia presso l’Università dello Utah: “The Limits of Data”, su Issues in Science and Technology 40, no. 2 (Winter 2024): 94–101 ( https://doi.org/10.58875/LUXD6515).

La tesi è tanto diretta quanto difficile da digerire (traduzione da inglese):

“[…]la raccolta dei dati comporta un compromesso. Otteniamo portabilità e aggregabilità al prezzo della sensibilità al contesto e delle sfumature. Cosa manca ai dati? I dati sono progettati per essere utilizzabili e comprensibili da persone molto diverse provenienti da contesti e background molto diversi. Pertanto, le procedure di raccolta dei dati tendono a filtrare la comprensione altamente basata sul contesto. […] Il potere dei dati è che possono essere raccolti da molte persone e formattati per viaggiare e aggregarsi. Il processo di rendere i dati portabili esclude anche modalità di comprensione sensibili, locali o altamente contestuali. […] E se i policy maker insistono nel fondare le loro politiche su set di dati pubblici su larga scala, allora stanno sistematicamente filtrando la discrezione, la sensibilità e l’esperienza contestuale dal loro processo decisionale.”

E ancora

“[…]Questa pericolosa separazione tra metrica e significato accelera quando le persone interiorizzano determinate metriche come valori fondamentali. Ho chiamato questo processo “cattura del valore”: quando i nostri valori più profondi vengono catturati dai parametri istituzionali e di conseguenza vengono diluiti o distorti. Gli accademici mirano ai tassi di citazione invece che alla comprensione reale; i giornalisti mirano al numero di clic invece che all’attendibilità della notizia. Nell’acquisizione del valore, esternalizziamo i nostri valori a istituzioni su larga scala. Quindi tutti questi filtri impersonali, decontestualizzanti vengono importati nei nostri valori fondamentali. E una volta interiorizzati questi valori spersonalizzati come nostri, non noteremo nemmeno ciò che stiamo trascurando.”

Come sottolinea l’autore, questo non vuol dire smettere di utilizzare i dati, ma iniziare a chiederci: “come sono stati raccolti?” e “da chi, con quali premesse e quali compromessi?” e ancora “a cosa stiamo rinunciando e quali pregiudizi ci stiamo portando dietro?”.

Senza entrare nel dettaglio di un approfondimento che sarebbe troppo complesso da riassumere qui, queste sono domande ancor più importanti quando decidiamo o decideremo di addestrare intelligenze artificiali o di utilizzarle. Domande che però, salvo accademici e ricercatori, non sempre ci facciamo e anzi finiamo per accettare i dati – soprattutto se ben presentati graficamente – come qualcosa di sicuro, assoluto e definitivo.

Tornando quindi al tema di quante imprese italiane utilizzano l’intelligenza artificiale, cito alcune delle fonti che ho trovato (ultimo anno):

1) ISTAT, Rilevazione ICT: nel 2023 il 4,36% delle piccole imprese, il 24,08 delle grandi e il 5,5% di tutte le imprese italiane con almeno 10 dipendenti.

2) ISTAT, Primi risultati del Censimento Permanente delle Imprese: nel biennio 2021-2022 erano il 13% delle imprese con almeno 3 dipendenti e, in particolare, il 19% delle piccole imprese e il 43% delle grandi.

3) Osservatori del Politecnico di Milano: nel 2023 61% delle grandi imprese ha all’attivo, almeno al livello di sperimentazione, un progetto di Intelligenza Artificiale mentre si scende al 18% tra le piccole e medie imprese (+3 punti percentuali rispetto al 2022).

4) Inapp (Istituto nazionale per l’analisi delle politiche pubbliche): la quota di imprese che nel 2022 adottava l’Intelligenza artificiale variava dall’1,5% nelle piccole aziende (con meno di 50 dipendenti) al 12% di quelle con oltre 250 dipendenti;

5) Unioncamere (2024): meno del 10% ha adottato l’IA, ma un altro 15% pianifica di investire in questa tecnologia nei prossimi tre anni.

6) IlSole24Ore (2023): meno del 6% delle PMI ha implementato progetti di IA, a fronte di una media europea del 7%

7) IBM (2024): 36% delle imprese italiane con almeno 1000 dipendenti

Chiedendo poi direttamente ad alcuni LLM: “Quante sono le imprese italiane che nel 2023 hanno utilizzato strumenti di intelligenza artificiale? Distingui tra grandi imprese e PMI”.

- Perplexity.ia risponde:

Nel 2023, in Italia, il 60% delle grandi imprese ha avviato progetti di intelligenza artificiale, mentre solo il 15% delle piccole e medie imprese ha fatto lo stesso. - Copilot (Microsoft):

Sei su dieci grandi imprese italiane hanno avviato progetti di intelligenza artificiale, almeno a livello di sperimentazione. Attualmente, meno del 10% delle PMI italiane ha adottato l’intelligenza artificiale. - ChatGPT (3.5) non ha dati aggiornati

Premesso che delle fonti citate mi affiderei a ISTAT, la cui metodologia permette anche confronti più omogenei con le imprese europee, appare chiaro come la differenza stia nel come la domanda è stata posta, con quale definizione sottostante di intelligenza artificiale, a quale campione di imprese (le grandi, quanto erano “grandi”? I settori erano distribuiti in modo coerente, così come i territori?) e con riferimento a quale stadio di adozione dell’intelligenza artificiale.

Inoltre, come anticipato nell’articolo citato, cosa implica che un’impresa utilizzi “strumenti di intelligenza artificiale”? Nella sintesi di queste statistiche, per quanto esistano altre sotto domande, perdiamo molte informazioni fondamentali per capire quanto una trasformazione digitale sia o meno di successo, quanta parte dell’impresa coinvolga, quanti dipendenti, con che esiti e quanto sia o meno efficace.

Nell’analisi di molti report presenti in rete, sembra che l’attenzione sia più dedicata a pubblicare un dato ritenuto originale e diverso rispetto ad approfondire quelli già disponibili.

Data-driven è diventata la locuzione di chi vuole distinguersi da coloro che decidono senza guardare minimamente ai dati. Pur riconoscendo che è sicuramente un passo in avanti, anzi un balzo rilevante che sarebbe bello veder compiere anche a tanta parte dei decision / policy makers italiani, spero di vedere sempre più analisi in cui si sviscerano i dati e le loro relazioni, più che produrne sempre di nuovi, gracili e contraddittori.

Devi fare login per commentare

Accedi